很可惜 T 。T 您现在还不是作者身份,不能自主发稿哦~

如有投稿需求,请把文章发送到邮箱tougao@appcpx.com,一经录用会有专人和您联系

咨询如何成为春羽作者请联系:鸟哥笔记小羽毛(ngbjxym)

作者:莲石东路@乌森

心之所向,无界成长。从底层架构到应用实战,聊聊炼数成金背后的故事。

持续更新数据治理、数据科学、数据可视化、空间计算系列文章。

前几天的一则新闻非常有意思。说的是2021年的美洲杯帆船赛上,新西兰酋长队利用强化学习测试水翼设计,他们称之为“AI水手”。”AI水手”在模拟器里学习如何应对风速和风向,学习调整14种不同的风帆和控制船只,经过不断的试错迭代,只用了八周时间就从一个什么都不懂的小白成长到战胜人类水手的水平。

有了”经验丰富”的”AI水手”的帮助,新西兰酋长队迭代设计的速度提升了十倍,得以用指数级速度测试更多船体设计并实现了性能优势,卫冕帆船赛的冠军。

这画面是不是很眼熟,没错,就跟阿尔法狗战胜人类顶级围起棋手那回一样,计算机再次用算力优势在一个领域里超越了人类。强化学习证明了自己在游戏以外领域的价值,帮助人们提升了设计工业产品的速度。

强化学习其实不是个新鲜概念了,只不过过去是被深度学习领域的CV、NLP等热门技术掩盖,现在重新被关注了而已。

那么,它具体是干什么的?简而言之,就是”自学成才”。

还是以Alpha Go举例。早期采用监督学习的 Alpha Go,需要输入大量人类棋手的下法、对弈棋局等数据,不断学习下法,也就是说,它是在“模仿”人类。但无论怎么模仿,它终究还是难以真正超越人类。到了采取了强化学习的Alpha Go Zero 的版本,它就不再对着人类的玩法照猫画虎了。了解到基本的规则以及最终要达到的目标后,就开始“随便下”,如果下赢了,就会得到奖励,然后指导下一步的决策;如果输了,就会有惩罚。在这种尝试——反馈——学习的过程中,完成自我进化。

对比于监督学习,强化学习的优势在于:无需在前期就输入大量数据,可以自我迭代完成学习的过程。对于许多场景来说,我们并没有太多可以参照的数据,而且有些小的变动都有可能会导致过去的经验没法直接套用,监督式的机器学习算法,学无可学。

正因为强化学习更接近于人类的思维模式,也难怪强化学习之父Richard Sutton说:” 我相信,从某种意义上讲,强化学习是人工智能的未来。”

学会下围棋只是强化学习开始,在产业界落地才是AI技术真正价值的所在。

好了,闲话不多说,下面来介绍一些强化学习的入门知识。

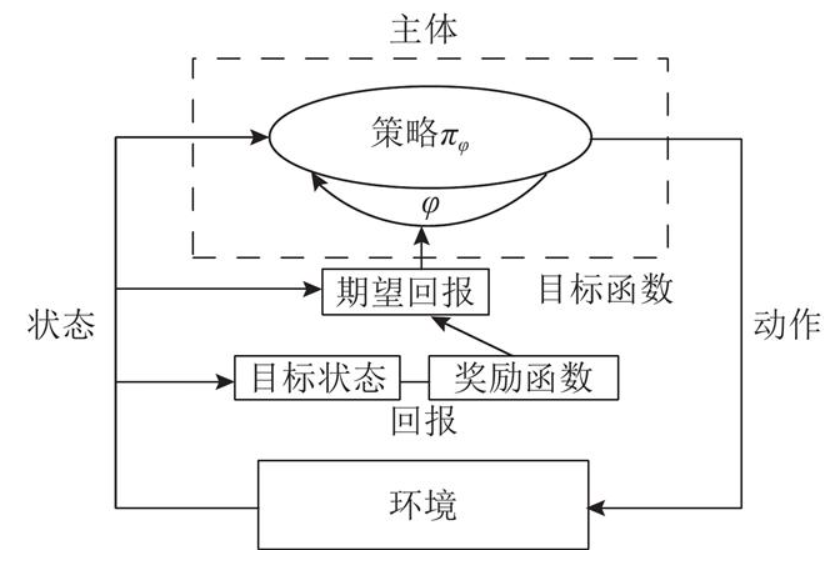

强化学习是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益。其灵感来源于心理学中的行为主义理论,即有机体如何在环境给予的奖励或惩罚的刺激下,逐步形成对刺激的预期,产生能获得最大利益的习惯性行为。在维基百科对强化学习的定义为:受到行为心理学的启发,强化学习主要关注智能体如何在环境中采取不同的行动,以最大限度地提高累积奖励。

就本质来说,强化学习是要解决做决策的问题,也就是自动决策问题,且可以连续做决策。

强化学习包含四个元素:智能体(agent),环境,行动/动作,奖励。

下面给出强化学习四大元素的定义:

智能体:强化学习的本体,作为学习者或者决策者。

环境:强化学习智能体以外的一切,主要由状态集组成。状态表示环境的数据。状态集是环境中所有可能的状态。

行动/动作:智能体可以做出的动作。动作集是智能体可以做出的所有动作。

奖励:智能体在执行一个动作后,获得的正/负奖励信号。奖励集是智能体可以获得所有反馈信息,正/负奖励信号亦可称作正/负反馈信号。

强化学习是从环境状态到动作的映射学习,该映射关系称为策略。通俗地说,智能体选择动作的思考过程即为策略。

智能体自动寻找在连续时间序列里的最优策略,而最优策略通常指最大化长期累积奖励。

可见,强化学习实际上是智能体在与环境进行交互的过程中,学会最佳决策序列。

强化学习通常分为两种,一种是无模型的,另一种是基于模型的。

无模型强化学习直接为参与者生成策略,所有的环境知识都嵌入到这个策略中。

① 策略梯度算法

策略梯度算法修改代理的策略以跟踪那些为其带来更高奖励的操作。这使这些算法符合策略,因此它们只能从算法内采取的操作中学习。

用于连接主义强化学习的简单统计梯度跟踪算法--1992年:提出了政策梯度的概念,提出了系统地增加产生高回报的行为的可能性的核心思想。

② 基于价值的算法

基于价值的算法会根据给定状态的感知价值来修改代理策略。这使得这些算法脱离策略,因为代理可以通过从任何策略中读取奖励函数来更新其内部状态结构。

Q学习--1992年:Q学习是现代强化学习中基于价值的经典方法,其中代理存储每个动作状态对的感知值,然后通知策略动作。

深度Q网络(DQN)--2015年:深度Q学习仅应用神经网络来模拟Q函数的每个动作和状态,这可以节省大量的计算资源,并有可能扩展到连续的时间动作空间。

③ Actor-Critic算法

行为者批判算法将基于策略和基于价值的方法结合在一起--通过对价值(critic)和行为(actor)使用单独的网络近似值。这两个网络相互配合,使彼此规范化并有望获得更稳定的结果。

Actor-Critic算法--2000年:提出了用两个单独的但相互交织的模型来生成控制策略的想法。

信任区域政策优化(TRPO)--2015年:基于actor critic途径,TRPO的作者希望在每个训练迭代中调整策略的变化,他们引入了一个关于KL散度的硬约束,即新策略分布中的信息变化。使用约束而不是惩罚,在实践中允许更大的训练步骤和更快的收敛。

近端政策优化(PPO)--2017年:PPO是对TRPO的改进,相较于之前的TRPO方法更加易于实现。

深度确定性策略梯度(DDPG)--2016年:DDPG将Q学习与策略梯度更新规则结合在一起,允许Q学习应用于许多连续控制环境。

双延迟深度确定性策略梯度(TD3)--2018年:TD3在DDPG的基础上进行了3个主要更改:1)同时学习两个Q函数,采用较低的Bellman估计值以减少方差;2)与Q函数相比,更新策略的频率更低;3)向目标操作添加噪音,以降低攻击性策略。

Soft Actor Critic(SAC)--2018年:为了在机器人实验中使用无模型的RL,作者希望提高样本效率,数据收集的广度和勘探的安全性。他们使用基于熵的RL来控制探索,并使用DDPG样式Q函数逼近进行连续控制。

随着样本复杂度下降和结果上升,许多人对无模型强化学习的应用感到非常兴奋。最近的研究已将这些方法的越来越多的部分用于物理实验,这使广泛使用的机器人的前景更近了一步。

基于模型的强化学习尝试建立环境知识,并利用这些知识采取明智的措施。

学习控制的概率推断(PILCO)--2011:它提出了一种基于高斯过程(GP)的策略搜索方法。

带有轨迹采样的概率集成(PETS)--2018:PETS将三个部分组合成一个功能算法:

1)由多个随机初始化的神经网络组成的动力学模型(模型集合);

2)基于粒子的传播算法;

3)和简单模型预测控制器。

基于模型的元策略优化(MB-MPO)--2018年:使用元学习来选择集成中哪个动态模型最能优化策略并减少模型偏差。这种元优化允许MBRL在更低的样本中更接近于渐进的无模型性能。

模型集成信任区域策略优化(ME-TRPO)--2018年:ME-TRPO是TRPO在模型集成上的应用,该模型集成被认为是环境的基本事实。对无模型版本的一个细微的添加是策略训练的停止条件,只有在策略迭代时,一定比例的模型不再看到改进时才会停止。

近年来,基于模型的强化学习有很多令人兴奋的应用,例如四轴飞行器和步行机器人。

-END-

本文为作者独立观点,不代表鸟哥笔记立场,未经允许不得转载。

《鸟哥笔记版权及免责申明》 如对文章、图片、字体等版权有疑问,请点击 反馈举报

Powered by QINGMOB PTE. LTD. © 2010-2025 上海青墨信息科技有限公司 沪ICP备2021034055号-6

我们致力于提供一个高质量内容的交流平台。为落实国家互联网信息办公室“依法管网、依法办网、依法上网”的要求,为完善跟帖评论自律管理,为了保护用户创造的内容、维护开放、真实、专业的平台氛围,我们团队将依据本公约中的条款对注册用户和发布在本平台的内容进行管理。平台鼓励用户创作、发布优质内容,同时也将采取必要措施管理违法、侵权或有其他不良影响的网络信息。

一、根据《网络信息内容生态治理规定》《中华人民共和国未成年人保护法》等法律法规,对以下违法、不良信息或存在危害的行为进行处理。

1. 违反法律法规的信息,主要表现为:

1)反对宪法所确定的基本原则;

2)危害国家安全,泄露国家秘密,颠覆国家政权,破坏国家统一,损害国家荣誉和利益;

3)侮辱、滥用英烈形象,歪曲、丑化、亵渎、否定英雄烈士事迹和精神,以侮辱、诽谤或者其他方式侵害英雄烈士的姓名、肖像、名誉、荣誉;

4)宣扬恐怖主义、极端主义或者煽动实施恐怖活动、极端主义活动;

5)煽动民族仇恨、民族歧视,破坏民族团结;

6)破坏国家宗教政策,宣扬邪教和封建迷信;

7)散布谣言,扰乱社会秩序,破坏社会稳定;

8)宣扬淫秽、色情、赌博、暴力、凶杀、恐怖或者教唆犯罪;

9)煽动非法集会、结社、游行、示威、聚众扰乱社会秩序;

10)侮辱或者诽谤他人,侵害他人名誉、隐私和其他合法权益;

11)通过网络以文字、图片、音视频等形式,对未成年人实施侮辱、诽谤、威胁或者恶意损害未成年人形象进行网络欺凌的;

12)危害未成年人身心健康的;

13)含有法律、行政法规禁止的其他内容;

2. 不友善:不尊重用户及其所贡献内容的信息或行为。主要表现为:

1)轻蔑:贬低、轻视他人及其劳动成果;

2)诽谤:捏造、散布虚假事实,损害他人名誉;

3)嘲讽:以比喻、夸张、侮辱性的手法对他人或其行为进行揭露或描述,以此来激怒他人;

4)挑衅:以不友好的方式激怒他人,意图使对方对自己的言论作出回应,蓄意制造事端;

5)羞辱:贬低他人的能力、行为、生理或身份特征,让对方难堪;

6)谩骂:以不文明的语言对他人进行负面评价;

7)歧视:煽动人群歧视、地域歧视等,针对他人的民族、种族、宗教、性取向、性别、年龄、地域、生理特征等身份或者归类的攻击;

8)威胁:许诺以不良的后果来迫使他人服从自己的意志;

3. 发布垃圾广告信息:以推广曝光为目的,发布影响用户体验、扰乱本网站秩序的内容,或进行相关行为。主要表现为:

1)多次发布包含售卖产品、提供服务、宣传推广内容的垃圾广告。包括但不限于以下几种形式:

2)单个帐号多次发布包含垃圾广告的内容;

3)多个广告帐号互相配合发布、传播包含垃圾广告的内容;

4)多次发布包含欺骗性外链的内容,如未注明的淘宝客链接、跳转网站等,诱骗用户点击链接

5)发布大量包含推广链接、产品、品牌等内容获取搜索引擎中的不正当曝光;

6)购买或出售帐号之间虚假地互动,发布干扰网站秩序的推广内容及相关交易。

7)发布包含欺骗性的恶意营销内容,如通过伪造经历、冒充他人等方式进行恶意营销;

8)使用特殊符号、图片等方式规避垃圾广告内容审核的广告内容。

4. 色情低俗信息,主要表现为:

1)包含自己或他人性经验的细节描述或露骨的感受描述;

2)涉及色情段子、两性笑话的低俗内容;

3)配图、头图中包含庸俗或挑逗性图片的内容;

4)带有性暗示、性挑逗等易使人产生性联想;

5)展现血腥、惊悚、残忍等致人身心不适;

6)炒作绯闻、丑闻、劣迹等;

7)宣扬低俗、庸俗、媚俗内容。

5. 不实信息,主要表现为:

1)可能存在事实性错误或者造谣等内容;

2)存在事实夸大、伪造虚假经历等误导他人的内容;

3)伪造身份、冒充他人,通过头像、用户名等个人信息暗示自己具有特定身份,或与特定机构或个人存在关联。

6. 传播封建迷信,主要表现为:

1)找人算命、测字、占卜、解梦、化解厄运、使用迷信方式治病;

2)求推荐算命看相大师;

3)针对具体风水等问题进行求助或咨询;

4)问自己或他人的八字、六爻、星盘、手相、面相、五行缺失,包括通过占卜方法问婚姻、前程、运势,东西宠物丢了能不能找回、取名改名等;

7. 文章标题党,主要表现为:

1)以各种夸张、猎奇、不合常理的表现手法等行为来诱导用户;

2)内容与标题之间存在严重不实或者原意扭曲;

3)使用夸张标题,内容与标题严重不符的。

8.「饭圈」乱象行为,主要表现为:

1)诱导未成年人应援集资、高额消费、投票打榜

2)粉丝互撕谩骂、拉踩引战、造谣攻击、人肉搜索、侵犯隐私

3)鼓动「饭圈」粉丝攀比炫富、奢靡享乐等行为

4)以号召粉丝、雇用网络水军、「养号」形式刷量控评等行为

5)通过「蹭热点」、制造话题等形式干扰舆论,影响传播秩序

9. 其他危害行为或内容,主要表现为:

1)可能引发未成年人模仿不安全行为和违反社会公德行为、诱导未成年人不良嗜好影响未成年人身心健康的;

2)不当评述自然灾害、重大事故等灾难的;

3)美化、粉饰侵略战争行为的;

4)法律、行政法规禁止,或可能对网络生态造成不良影响的其他内容。

二、违规处罚

本网站通过主动发现和接受用户举报两种方式收集违规行为信息。所有有意的降低内容质量、伤害平台氛围及欺凌未成年人或危害未成年人身心健康的行为都是不能容忍的。

当一个用户发布违规内容时,本网站将依据相关用户违规情节严重程度,对帐号进行禁言 1 天、7 天、15 天直至永久禁言或封停账号的处罚。当涉及欺凌未成年人、危害未成年人身心健康、通过作弊手段注册、使用帐号,或者滥用多个帐号发布违规内容时,本网站将加重处罚。

三、申诉

随着平台管理经验的不断丰富,本网站出于维护本网站氛围和秩序的目的,将不断完善本公约。

如果本网站用户对本网站基于本公约规定做出的处理有异议,可以通过「建议反馈」功能向本网站进行反馈。

(规则的最终解释权归属本网站所有)